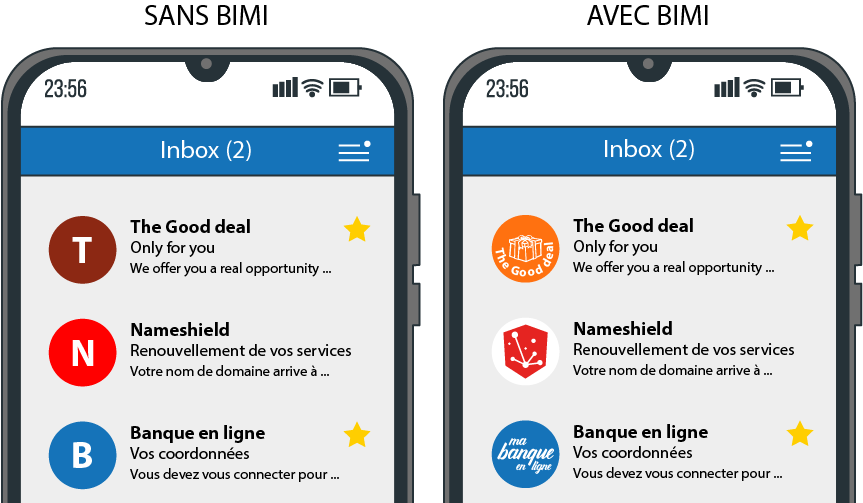

BIMI (Brand Indicators for Message Identification) permet d’authentifier vos emails et de renforcer la confiance de vos clients en affichant votre logo dans leur boîte de réception. VMC (Verified Mark Certificate) est un certificat associé à BIMI, garantissant l’authenticité du logo affiché.

Qu’est-ce que BIMI?

BIMI est une initiative de l’industrie visant à normaliser l’utilisation et l’affichage des logos des marques dans les clients de messagerie. En plaçant le logo d’une marque ou d’une entreprise à côté d’un e-mail, celui-ci est plus facilement identifiable par les clients et les utilisateurs, installe un sentiment de légitimité et de confiance, impacte significativement les taux d’ouverture et augmente la protection des consommateurs contre les e-mails frauduleux.

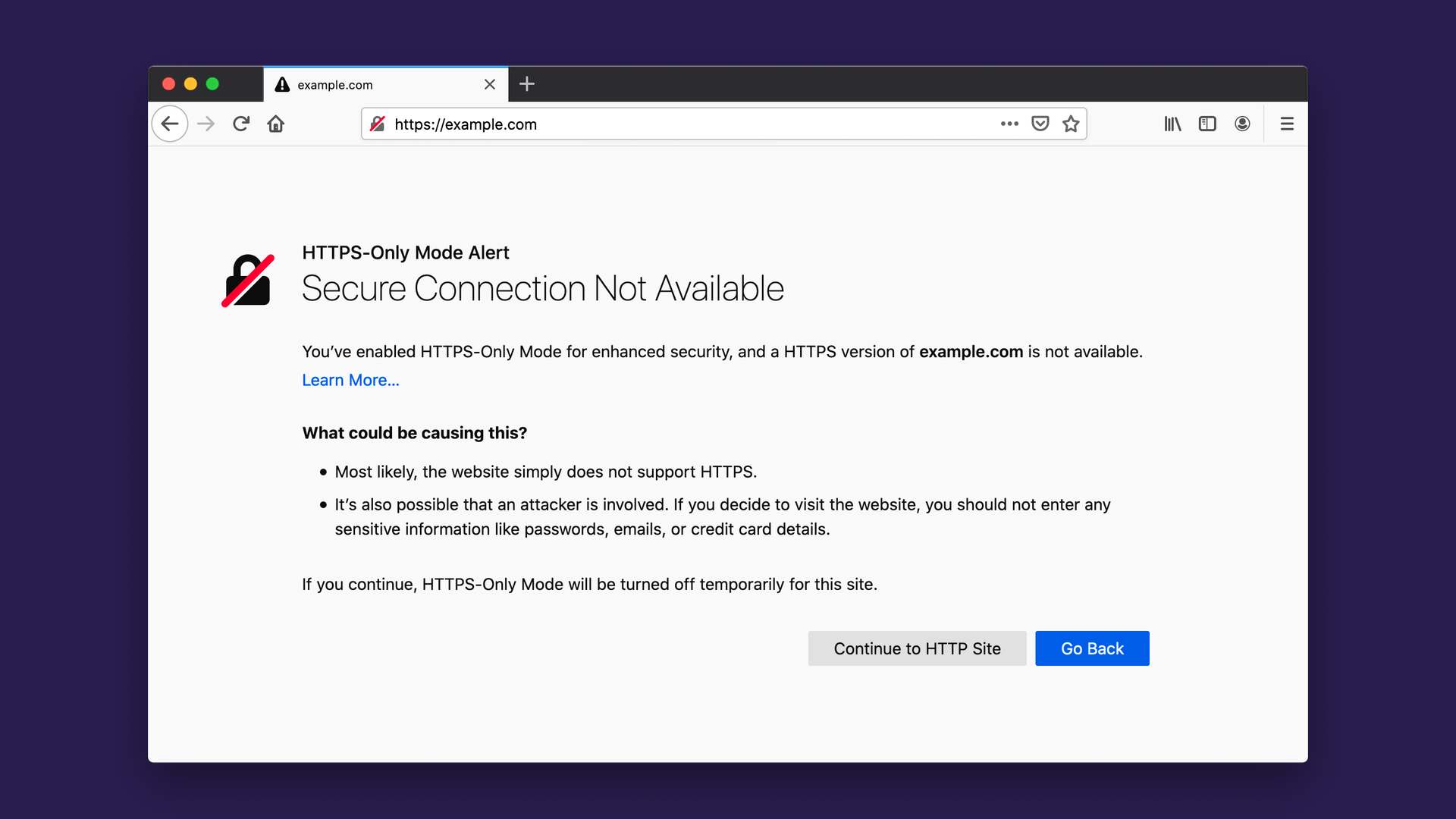

Techniquement parlant, BIMI est une technologie de sécurité émergente qui fonctionne en complément des protocoles DKIM, SPF et DMARC pour protéger votre nom de domaine contre l’utilisation par des acteurs malveillants pour envoyer des e-mails frauduleux.

Avant BIMI, les étapes pour faire apparaître votre logo à côté d’un e-mail étaient spécifiques à chaque service de messagerie auquel votre message était envoyé. Parfois, le processus était entièrement manuel ou s’appuyait sur d’autres applications pour agréger les informations de votre marque et les partager sur les plateformes participantes.

Le groupe AuthIndicators, qui comprend des fournisseurs de services de messagerie tels que Google, Verizon Media, IONOS by 1&1 et Fastmail, travaille à la mise en œuvre de BIMI dans les clients de messagerie les plus courants. De nombreux acteurs ont déjà adopté BIMI, d’autres sont en cours, les positions de Microsoft et d’Apple sont attendues pour faire définitivement adopter ce standard.

Pourquoi BIMI est important ?

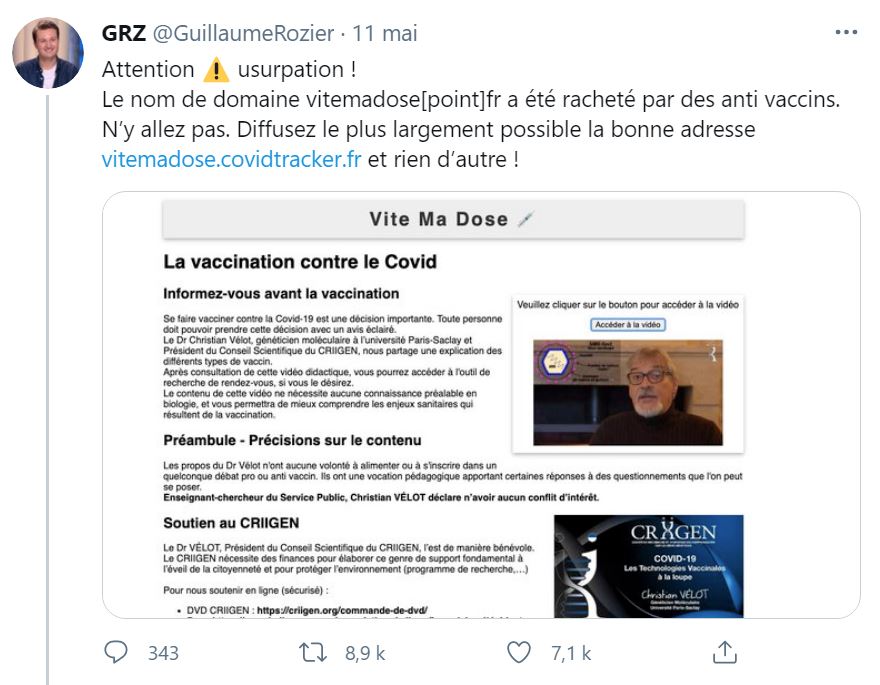

Pour compléter l’arsenal de protection d’une marque sur Internet, plus particulièrement contre les tentatives de détournement via des e-mails frauduleux de type spoofing dont le but est de tromper l’utilisateur et de l’amener vers des sites de phishing.

.

306 Milliards d’e-mails ont circulé en 2020 dans le monde, avec une proportion toujours croissante de mails frauduleux détournant des marques.

Pour augmenter la désidérabilité des e-mails, notamment dans les campagnes marketing. L’implémentation de BIMI et plus largement des protocoles et certificats de sécurité sur le nom de domaine associé à une marque est indispensable aujourd’hui et a un impact majeur sur la réputation en ligne.

Parce que c’est en train de devenir un standard du marché, simple à mettre en place contrairement au nombre de solutions de lutte contre les e-mails frauduleux existantes, souvent difficiles à tester et à mettre en œuvre.

Comment BIMI fonctionne ?

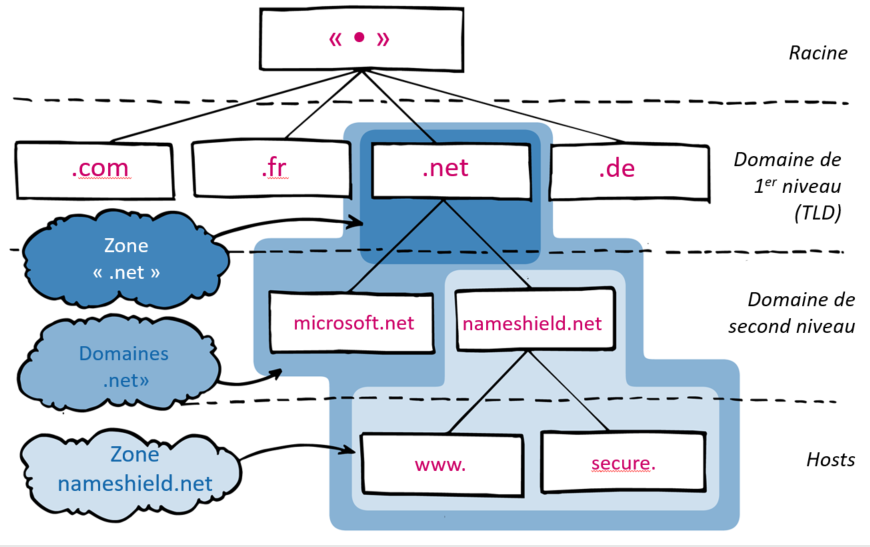

BIMI utilise un processus en plusieurs étapes pour valider les e-mails en s’assurant qu’ils sont réellement associés au nom de domaine de l’expéditeur. Les expéditeurs doivent ajouter un enregistrement DNS de type TXT dédié à BIMI.

Pour que BIMI fonctionne, les noms de domaine doivent également disposer de plusieurs autres protections contre la fraude, notamment :

- SPF (Sender Policy Framework) : authentifie les e-mails en identifiant les serveurs de messagerie autorisés à envoyer à partir de noms de domaine spécifiques ;

- DKIM (DomainKeys Identified Mail) : ajoute une signature numérique à chaque e-mail pour vérifier qu’il a été envoyé depuis un nom de domaine autorisé ;

- DMARC (Domain-Based Message Authentication, Reporting, and Conformance) : confirme les enregistrements SPF et DKIM et spécifie comment les e-mails non conformes doivent être traités.

Lorsque des e-mails sont envoyés en utilisant BIMI, le serveur de messagerie de réception effectuera d’abord l’authentification DMARC/DKIM standard et la validation SPF. Si l’e-mail passe ces vérifications, le serveur de messagerie vérifiera s’il a un enregistrement BIMI valide et affichera le logo de la marque.

Comment BIMI interagit-il avec DMARC, DKIM et SPF ?

La première étape vers l’utilisation de BIMI pour afficher un logo consiste à mettre en œuvre DMARC. Ceci est stocké en tant qu’enregistrement DNS de type TXT sur le nom de domaine. Pour que DMARC fonctionne avec BIMI, la politique de rejet dans cet enregistrement doit être p=quarantine ou p=reject pour tous les e-mails envoyés depuis votre domaine.

BIMI nécessite DMARC… et DMARC nécessite que votre nom de domaine ait des enregistrements DKIM pour fonctionner. Si DMARC ne nécessite que SPF ou DKIM pour fonctionner, il est cependant préférable d’inclure des enregistrements SPF pour plus de sécurité lors de l’utilisation de BIMI. Ces 2 outils de sécurité sont également stockés sous forme d’enregistrements DNS TXT dans la zone du nom de domaine.

VMC, le dernier maillon de la chaîne

Un Verified Mark Certificate (ou « certificat de marque vérifié ») est un certificat numérique qui authentifie la propriété d’un logo, et qui vient compléter l’utilisation de BIMI dans les clients de messagerie tels que Gmail.

Le certificat VMC garantit l’authenticité du logo affiché, nécessairement propriété du titulaire du nom de domaine envoyant l’e-mail. C’est le dernier maillon de la chaîne pour garantir l’authenticité du mail reçu.

Lorsque vous envoyez un e-mail à un contact, le serveur de messagerie destinataire qui gère sa boîte de réception prendra l’URL de la balise qui indique où le logo doit être affiché. Il vérifiera ensuite le certificat VMC pour s’assurer que le bon logo est utilisé. Une fois le logo vérifié par le VMC, BIMI l’affichera à côté de l’e-mail dans la boîte de réception.

Pour obtenir un certificat VMC, l’implémentation de DMARC sur le nom de domaine est un prérequis. S’ensuit alors un processus d’authentification renforcé auprès d’une Autorité de Certification qui validera l’identité de l’Organisation, l’enregistrement du logo auprès d’un organisme certifié et délivrera le certificat à la suite d’un one to one devant un notaire.

Selon les pays, les offices d’enregistrement des logos peuvent varier ainsi que les règles d’acceptation pour émettre le certificat. Les notions à garder en tête, les marques déposées autorisées peuvent être :

- Marques de dessins : composées uniquement d’un dessin ;

- Marques verbales : contiennent des mots, des lettres et/ou des chiffres, sans police, taille, couleur ou style particulier ;

- Marques combinées : inclure une combinaison de mots avec un dessin, des lettres stylisées ou des chiffres.

Bien que ce ne soit pas une exigence pour la mise en œuvre de BIMI sur votre nom de domaine pour le moment, VMC devrait faire partie de la norme à l’avenir.

Entrust Datacard et DigiCert sont les 2 premières sociétés à délivrer des certificats VMC pour la norme BIMI. Nameshield est partenaire des deux sociétés et vous accompagne pour l’obtention de certificats VMC. Vous pouvez contacter directement notre service certificats pour toute question sur le sujet.

BIMI + VMC = Garantie d’authenticité

BIMI, VMC… et Nameshield

Nameshield accompagne désormais ses clients sur tous les aspects de la mise en place des protocoles DMARC, SPF, DKIM, mais aussi BIMI et l’obtention des certificats VMC associés. Le nom de domaine est au cœur de la mise en place de ces différents protocoles. Notre métier historique de registrar et de gestionnaire de zones DNS nous permet aujourd’hui d’accompagner nos clients sur ces sujets majeurs de la lutte contre la fraude en ligne et d’augmentation de la désidérabilité des e-mails.